En la medicina, por ejemplo, la nanotecnología es puntera en las investigaciones del trato de las células cancerígenas o en sistemas de transporte de medicamentos en la sangre de formas muy precisas. Para hacernos una idea de los usos más cotidianos de las nanopartículas, las podemos encontrar en cremas solares, haciendo que estas no queden tan visibles en la piel, o en las pelotas de tenis Wilson, que llevan una capa de nanopartículas de arcilla que las hacen más resistentes y que hacen que el aire no pueda escapar de su interior tan fácilmente.

Los descubrimientos de las nanopartículas y sus propiedades no dejan de sorprender a la comunidad científica, ya que al ser una ciencia tan nueva, todavía presenta muchas dudas y curiosidades.

Nanohex: nanofluidos y ventajas térmicas

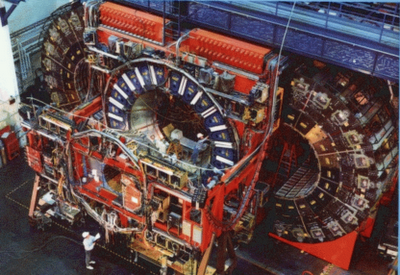

Nanohex es un proyecto que involucra a 12 organizaciones de 6 países diferentes. Entre ellos encontramos ENEA, en Casaccia, a 25 kilómetros al norte de Roma. Este centro de investigación cuenta con unas instalaciones que se extienden a lo largo de 90 hectáreas, y con más de 1.400 trabajadores.

El proyecto Nanohex, pretende desarrollar nanofluidos como líquidos refrigerantes para su aplicación industrial. Las nanopartículas han demostrado que tienen propiedades térmicas de difusión muy buenas, haciendo que los líquidos refrigerantes mejoren sus propiedades, ya que dispersan el calor más rápido, mejor y de una manera más eficiente.

El proyecto comenzó en 2009 y se prevé que se alargue hasta 2011. En el centro que ENEA tiene en Casaccia hay dos unidades involucradas: el laboratorio de espectroscopía láser en materiales funcionales y el laboratorio de termofluidodinámica aplicada a los sistemas energéticos.

Mauro Falconieri es el jefe del laboratorio de espectroscopía láser y materiales funcionales. La espectroscopía láser estudia como los materiales reaccionan cuando se produce un cambio de energía en su interior: a través de la señal que estos emiten al ser excitados con el láser se pueden estudiar múltiples características. Este es el método que escogió Mauro en su misión dentro del proyecto Nanohex.

Flaminia Rondino, estudiante de post-doctorado, también forma parte de este proyecto. Su misión es estudiar las propiedades térmicas y dispersivas de las nanopartículas de titanio, para así conseguir el nanofluido con mejores cualidades. En un futuro también tienen intención de estudiar las de silicio. En Frascatti, ENEA tiene otras instalaciones donde se encargan de producir las muestras de nanopartículas. Pero su estudio mediante la espectroscopía láser es todo un proceso, sólo para que los láseres mediante los que se hará el experimento estén perfectamente alineados se pueden necesitar semanas de preparación.

El otro departamento en Casaccia, el laboratorio de termofluidodinámica aplicada a sistemas energéticos, estudia las propiedades de estos nanofluidos comparados a tiempo real con otros refrigerantes comunes en el uso industrial como el agua. Al compararlos a tiempo real y en mismas condiciones, pueden averiguar que ventajas supone el nanofluido respecto al agua en cuanto a sus propiedades térmicas pero también en las propiedades corrosivas, otro aspecto que se tiene que tener en cuenta ya que tiene es muy importante de cara a la aplicación industrial.

Nanohex y sus propósitos

Para que un proyecto como este funcione tiene que haber industrias involucradas, que el que se implique en el consumidor final. Y éste es el caso de Nanohex, cuyos dos mayores objetivos públicos involucrados son Thermacore Europe, que es el mayor proveedor de líquidos refrigerantes para centros de datos, y Siemens, que lo quiere aplicar en la tecnología electrónica de los trenes.

El uso de nanofludios por parte de las empresas puede suponer muchas ventajas: los nanofluidos, al ser más eficientes tienen mejor conductividad y propiedades térmicas pueden suponer una mejora en lo que supone al ahorro energético. También hay que tener en cuenta la reducción de espacio que se gana al no tener que usar tantas cantidades de líquido, algo muy interesante para la industria aeroespacial. También hay que tener en cuenta la reducción en las emisiones de dióxido de carbono.

Fuente

tendencias21.net

mundociencia.portalmundos.com