Un cordial saludo de Manu y Leandro

Este blog ha sido creado por Manu Gutiérrez y Leandro Mesas, como parte de la asignatura Proyecto Integrado de 2º BACH, de la rama tecnológica. Pretende ser una vía de divulgación científica. Tenemos tres líneas de entradas principales, "Curiosidades", "Materiales del Futuro" y "Tecnologías para el Futuro", además de noticias de actualidad sin clasificar. Contacto: manu.guti.to@gmail.com

martes, 5 de julio de 2011

DESPEDIDA

Un cordial saludo de Manu y Leandro

viernes, 29 de abril de 2011

Donaciones de sangre

Primero hablaremos un poco sobre la sangre en sí. Como todos sabemos, la sangre está compuesta por una fase líquida (el plasma sanguíneo) y una fase sólida (glóbulos blancos o leucocitos, glóbulos rojos o eritrocitos y plaquetas o trombocitos). Su función principal es el transporte de oxígeno de los pulmones a las células y el transporte de dióxido de carbono de las células a los pulmones.

En cuanto a los grupos sanguíneos, existen cuatro tipos principales: A, B, AB y O, en función de los antígenos que poseamos. Aparte encontramos el factor Rhesus, que también viene determinado por una serie de antígenos. Los que los poseen tienen Rh positivo, los que no, Rh negativo. Para determinar la compatibilidad hay que tener en cuenta ambos factores, tal y como se recoge en la siguiente tabla:

Los requisitos para poder donar sangre o plasma son:

- Tener más de 18 años.

- Pesar más de 50kg.

- Sentirse bien.

- No estar en ayunas.

- No haber donado sangre en 4 meses.

Los hombres pueden donar sangre 4 veces al año; las mujeres sólo 3. Existen más condiciones para establecer quién puede donar, que se recogen en los enlaces siguientes:

- Se puede donar aunque...

- No pueden donar...

- Temporalmente no pueden donar...

En cuanto a la donación en sí, el proceso consta de varias partes:

- Filiación del donante: se recogen los datos del donante. Es necesario llevar el DNI.

- Autoexclusión: se entrega un formulario con las razones por las que la donación está prohibida (enfermedades, consumo de drogas, relaciones sexuales de riesgo, ...)

- Entrevista médica: el médico entrevista al donante para determinar factores de riesgo.

- Exploración: se toman el pulso, la presión sanguínea y se realiza una prueba para detectar anemia.

- Extracción: empleando material estéril y desechable, se extraen 450mL de sangre, además de muestras para realizar pruebas.

Tras donar sangre está altamente desaconsejado beber alcohol o fumar en 2 horas o hacer ejercicio en 12 horas. Tampoco se puede coger peso con el brazo del que se ha extraído la sangre. Se recomienda ingerir líquidos.

La sangre y sus distintos componentes se utilizan para diversos fines: tratamiento de enfermedades, reposición de sangre ante hemorragias, transplantes y operaciones, ... Para que nos hagamos una idea, para una operación de cadera se necesitan de 6 a 8 unidades (bolsas de 450mL), en un parto complicado de 4 a 6, en un accidente de 20 a 30, en caso de aneurisma roto de 30 a 40, en un transplante de corazón alrededor de 20, en uno de hígado alrededor de 30 y en uno de médula ósea alrededor de 50. En cuanto a los beneficios para el donante, cabe destacar la renovación de la sangre y el hecho de que los análisis pueden detectar enfermedades que el donante desconocía. Y, por supuesto, ¡la coca-cola y el dulce de turno gratis!

A los que os interese la donación, hay dos lugares posibles para realizarla. Existen centros de donación de sangre fijos (podéis buscar el más cercano a vosotros), y para los pueblos pequeños, existen unidades móviles que se desplazan para realizar las extracciones. Más info aquí.

No me queda nada más que decir, salvo que es un pequeño gesto que puede salvar muchas vidas.

martes, 12 de abril de 2011

Curiosidades IV: ¿Cuál es el elemento químico más antiecológico?

¿ Qué cantidad se considera tóxica ?

Todas las cosas que nos rodean puede ser un veneno mortal, si se come, se bebe o inhala demasiado de ese producto.

Sin embargo, hay grandes diferencias en las cantidades. Si bebe unos quince litros de agua al dia no sobrevivirá, en el otro extremo de la balanza está que, sólo dos milmillonésimas de gramo de la toxina botulínica, procedente de la bacteria botulínica, son suficientes para matarle.Todos los productos químicos clorados están entre estos límites. Por ejemplo, puede comer kilos de polvo de PVC; no es tóxico en esa dosis, no podrá digerirlos y dejarán al organismo tal como está. El ácido clorhídrico, un elemento indispensable de nuestro sistema digestivo, únicamente será mortal a altas concentraciones. El cloro es un veneno a nivel medio y la dioxina TCDD es el veneno más potente que la humanidad haya fabricado jamás (pero no de forma voluntaria).

Fuente:

wikipedia.es

martes, 5 de abril de 2011

Tecnologías para el futuro VIII: propulsión térmica para cohetes

martes, 29 de marzo de 2011

Curiosidades III: ¿Qué produce el ruido de un trueno?

Primera teoría:

Segunda teoría:

Imaginemos muchas nubes puestas unas sobre otras, compuestas alternativamente de vapores y exalaciones que el calor ha sacado de la tierra con abundancia en diferentes ocasiones.

Consideremos después las nubes superiores caer sobre las inferiores, sin que estas puedan descender, por hallarse sostenidas a alguna distancia de la tierra por otro viento inferior, y las causas comunes que las sostienen. En este caso hallándose el aire que hay entre la nube superior y la inferior, forzado a dejar aquel espacio, el que está en las estremidaes de las dos nubes, huye inmediatamente, dando lugar por este medio a que los extremos de la nube superior, desciendan algo más que su centro, encerrando él una gran porción de aire, que debiendo acabar de salir por un carril estrecho e irregular, ocasiona el ruido que se oye, originado de la violencia y opresión con que huye; y así se puede muchas veces oír el ruido del trueno sin ver el relámpago.

Pero si las exalaciones de azufre y nitrogeno que algunas veces se encuentran entre dos nubes, llegan a inflamarse por alguna agitación violenta, se comunica repentinamente esta llama a todas las materias inflamables que las circuyen, dilata el aire extraordinariamente, y produce los relámpagos, dando ocasión a que en lugar del ruido regular del trueno, se oiga un ruido espantoso, y que parezca encendido el aire. Y como las exhalaciones rechazadas y agitadas por todas partes, pueden inflamarse sin que la nube superior caiga con violencia sobre la inferior para causar ruido, puede suceder que veamos el relámpago sin oír el trueno.

La continuación y repetición del trueno proceden de una especie de eco que se forma en las nubes, a lo cual pueden contribuir también muchos cuerpos endurecidos que están sobre la tierra, y hacen repetir muchas veces el estrépito que se oye después del ruido del trueno. Cuando el fuego del trueno es impelido con violencia hacia la tierra y hace en ella algunos estragos, le damos el nombre de rayo; muchas veces mata hombres y animales; quema y derriba árboles y edificios, y abrasa cuanto encuentra.

Fuente:

wikipedia.es

domingo, 27 de marzo de 2011

Tecnologías para el futuro VII: Avances en computación cuántica

Hace unos diez años se produjo el primer intento de construir un ordenador que trabajase con las reglas de la mecánica cuántica, llevado a cabo por físicos de la Stanford en conjunto con IBM. Su principal utilidad era a la hora de factorizar números, un problema para el que los ordenadores convencionales son cuanto menos poco eficientes. Este ordenador tenía 7 qbits, equivalentes a 128 bits en un procesador tradicional. Desde entonces no ha habido grandes avances hasta que, recientemente, un equipo de Harvard liderado por Mike Grinolds ha anunciado la construcción de una máquina de resonancia magnética con un cabezal del tamaño de la cabeza de un alfiler, capaz de trabajar con átómos de nitrógeno incrustados en diamante.

Fue en 2001 cuando se pensó en utilizar la tecnología de la resonancia magnética nuclear, la misma que se usa en medicina, para manipular los núcleos atómicos de una molécula de forma independiente. El proceso se inicia con el envío de ondas de radio a los núcleos, cuyo eco es luego recogido. Esta técnica funciona con muchas moléculas, como la cafeína, el alcohol, la acetona o la usada en el ordenador de IBM/Stanford, un compuesto denominado perfluorobutadienyl iron.

El talón de Aquiles de esta técnica es que la señal devuelta por una molécula es demasiado débil. El cabezal creado en Harvard permite estimular y controlar la resonancia magnética con electrones individuales. El motivo de que usen átomos de nitrógeno incrustados en diamante es que las reacciones de nitrógeno emiten muchos fotones, por lo que son fácilmente detectables; además, el diamante ofrece una excelente protección contra interferencias externas.

El camino de la computación cuántica se ha vuelto a abrir. Además, quien desarrolle un ordenador cuántico funcional, con toda probabilidad, será galardonado con el Nobel de Física.

Fuentes:

www.neoteo.com

martes, 22 de marzo de 2011

Tecnologías para el futuro VI: turbinas que optimizan la conversión termoeléctrica

Ingenieros y científicos del Sandia National Laboratories han diseñado un nuevo sistema de turbinas, basado en el estudio del dióxido de carbono en estado supercrítico y en las turbinas de ciclo Brayton. Según numerosos especialistas, el dióxido de carbono supercrítico tiene un gran interés industrial para la generación de energía, tanto en fuentes renovables como no renovables. Se espera que se incremente la eficiencia alrededor de un 50% con respecto al ciclo Rankine, que además ocupa 30 veces más tamaño que las turbinas de ciclo Brayton y tiene unos índices de corrosión mucho más elevados.

El ciclo Brayton de generación de energía podría proporcionar 20MW de energía eléctrica en un espacio de sólamente cuatro metros cúbicos.

El nuevo sistema, que se encuentra en fase de optimización tecnológica, consiste básicamente en un motor a reacción que se ejecuta en un líquido a altas temperaturas. Existe además una variante, el uso de ciclos Brayton con helio en lugar de dióxido de carbono supercrítico. Sin embargo, el dióxido de carbono trabaja a una temperatura considerablemente más baja, además de ser más compacto. De esta forma, se reducen cuantiosamente los costes de producción y se aumenta la eficiencia.

Las propiedades del dióxido de carbono supercrítico a temperaturas superiores a los 500ºC y presiones por encima de los 7,6MPa permiten que el sistema pueda funcionar con una eficiencia térmica altísima, por encima de los indicadores de una planta de carbón de gran potencia. En comparación con otras turbinas de gas, el nuevo sistema podría aumentar la potencia eléctrica por unidad de combustible en un 40% o más.

Fuentes:

es.wikipedia.org

www.tendencias21.net

sábado, 19 de marzo de 2011

Curiosidades II: ¿Quién inventó el número 0?

- El número cero es aquel que indica ausencia de unidades.

- En la serie de los números naturales el origen de ella.

- En la serie entera indica el punto inicial para medir o contar en ambos sentido de la serie.

- En definitiva cero significa ausencia de unidades en las magnitudes absolutas y origen en las magnitudes relativas.

- En las magnitudes relativas la adición de (+S) y (–S) da siempre cero. Asi (+S)+(-S) = 0.

- Todo número multiplicado por cero da cero, así S x 0 = 0.

- Dividir cualquier número S por cero (S/0) no tiene sentido y dividir 0/0 es infinito. Asi 0/0 es igual a infinitos números ya que cualquier Sx0=0.

- Una potencia elevada a cero da la unidad, ya que S^N / S^N =S^N −N = S^0 = 1 ya que dividendo y divisor son iguales.

jueves, 17 de marzo de 2011

La tabla periódica de las formas

Un equipo de matemáticos del Imperial College de Londres ha decidido emular al ruso Mendeléiev, pero como la tabla periódica de los elementos ya estaba inventada, han decidido crear una tabla periódica de las formas. De esta forma, pretenden clasificar las formas indivisibles en tres, cuatro y cinco dimensiones, aquellas que son como los "átomos" de las formas más complejas. De esta forma, pretenden crear una tabla de formas similar a la de los elementos.

En la tabla periódica de los elementos se clasifican los átomos con los que se forman todas las cosas, y además se explican sus propiedades químicas más importantes. La tabla de las formas, por su parte, clasificará y enumerará las propiedades específicas de las formas indivisibles. Según publica el Imperial College, cuando se decida qué formas incluirá la tabla se procederá a calcular las ecuaciones que las describen, con lo que esperan aumentar los conocimientos de las propiedades geométricas de éstas, y también aprender cómo combinarlas con otras.

El director del proyecto, Alessio Corti, afirma que la tabla periódica de las formas contendrá un número ingente de formas "que no podrá colgarse como un póster en la pared", pero que sí se convertirá en una herramienta tan útil como la tabla periódica de los elementos.

Lo más importante es que, además de incluir las formas "cotidianas" (tridimensionales) se incluirán formas de cuatro y cinco dimensiones, importantísimas para la ciencia. Según Tom Coates, el experto en topología y geometría del proyecto, “La mayoría de la gente está familiarizada con la idea de las formas tridimensionales. Para los que no trabajan en nuestro campo, resulta difícil imaginar formas de cuatro o cinco dimensiones. Sin embargo, comprender este tipo de formas es realmente importante para muchos aspectos de la ciencia”. Por ejemplo, según explica Coates, en robótica sería necesario calcular la ecuación de una forma de cinco dimensiones para averiguar cómo enseñar a un robot a mirar un objeto y mover su propio brazo para coger dicho objeto.

El presente proyecto, que presumiblemente concluirá en tres años, es financiado por el Engineering and Physical Sciences Research Council (EPSRC), Leverhulme Trust, la Royal Society y el European Research Council (ERC).

Fuentes:

www.tendencias21.net (noticia e imágenes)

es.wikipedia.org (imágenes)

www.mcgraw-hill.es (imágenes)

martes, 15 de marzo de 2011

Tecnologías para el futuro V: Sistema para la alerta de tsunamis en menos de 10 minutos.

Este sistema a recivido el nombre de RTerg (Real-Time Earthquake Energy), y servirá para reducir el número de muertes por tsunami ya que dará más tiempo a los habitantes de áreas que tienen mayor posibilidad de padecer uno de estos fenómenos para ponerse a salvo.

Cuando se produce un terremoto, lo normal es que una extensa zona de subducción se rompa a una velocidad de 3 Km/S , y a una profundidad entre 20 y 50 metros por debajo de la superficie terrestre. Dada esta profundidad, las deformaciones verticales de la corteza que provoca el terremoto son aplanadas horizontalmente, por lo que el tamaño de elevación de la corteza tiende a ser pequeño. Si el terremoto se produce en el océano, las olas resultantes pueden medir alrededor de 20 Cm.

Sin embargo, los maremotos que dan lugar a tsunamis funcionan de un modo distinto. Cuando éstos se producen, la ruptura de la corteza se produce más lentamente que en el casao anterior y se propaga hacia arriba, provocando elevaciones verticales en la corteza mucho más altas de lo normal. Como resultado, las olas también aumentan,llegando a alcanzar alturas de entre 10 y 20 metros, en entornos cercanos a las costa.

Los terremotos que provocan tsunamis son más lentos, duran más y propagan una energía menos eficiente. Los elementos que mide el RTerg son el tamaño de las olas, un tiempo de duración excesivo de la ruptura de la corteza, un movimiento de ésta predominantemente a escasa profundidad, y las deficiencias en ratios de energía a tiempo real. Estas mediciones son realizadas por el sistema mediante algoritmos. El proceso completo sería el siguiente: el RTerg recibe una notificación, procedente de alguno de los centros de alerta por tsunami, de que se ha producido un terremoto. Esta notificación señala al sistema la localización del terremoto, su profundidad y su magnitud aproximada.

EN caso de que la magnitud del terremoto sea de 6,5 o más en la escala Richter, en un minuto el sistema recibe, además, otros datos sobre el fenómeno, procedentes de unas 150 estaciones sísmicas de todo el mundo. Una vez recopilados estos datos, el RTerg aplica sus algoritmos a cada segundo de ruptura, y determina si el terremoto se convertirá en un terremoto tsunami.

En la mayoría de los casos de terremotos tsunami, las inundaciones costeras no se producen hasta 30 ó 40 minutos después de que se produzca el terremoto. Por tanto, si el RTerg puede lanzar un aviso en alrededor de 10 minutos, quedarán unos 20 ó 30 minutos para que la población se ponga a salvo.

Tendencias21.net

larazón.es

jueves, 10 de marzo de 2011

Tecnologías para el futuro IV: televisiones de nanocristal

La más obsoleta, aunque aún se utiliza, es la CRT. Las siglas significan, en inglés, Tubo de Rayos Catódicos. La tecnología fue inventada por William Crookes en 1895 y desarrollada por Ferdinand Braun en 1897, aunque no se usó hasta 1940 con la aparición de los primeros televisores. Funciona mediante el impacto de electrones (rayos catódicos, como se llamaban cuando se descubrieron) en una pantalla de fósforo, con píxeles individuales formados a su vez por tres píxeles de colores (rojo, azul y verde) para crear colores según la intensidad con la que brillan cada uno de los píxeles. El tubo de rayos catódicos hace impactar los electrones contra la pantalla empezando en la esquina superior izquierda, avanzando a lo largo de la fila y bajando a la siguiente al finalizar, cambiando la trayectoria gracias a unos deflectores. Esto se produce con gran rapidez, por lo que da la impresión de ser una imagen contínua. Su principal desventaja es que emiten radiación nociva para los ojos, peor cuanto más cerca (monitores de ordenador).

Otra de las tecnologías más usadas es el PDP, o "Plasma Display Panel", más conocida simplemente como plasma. Se usa habitualmente en pantallas de gran tamaño, mayores de 37 pulgadas de diagonal. La pantalla consta de muchas celdas individuales entre dos paneles de cristal que contienen una mezcla de gases nobles (neón y xenón). El gas se convierte en plasma electrónicamente, provocando que una sustancia fosforecente (que no es fósforo, a diferencia del CRT) emita luz. Proporcionan una gran luminosidad y gran calidad de imagen, a costa de emitir una gran cantidad de calor. Son muy poco eficientes, energéticamente hablando.

La tecnología más extendida hoy en día es el LCD, de las siglas en inglés de Pantalla de Cristal Líquido. Son pantallas planas y delgadas, formadas por píxeles colocados delante de una fuente emisora de luz (en las pantallas más actuales se utilizan diodos LED, que consumen muy poca energía, a costa de una menor vida útil). Su funcionamiento es muy complejo y existen diversos sistemas, pero de forma general lo que se hace es filtrar la luz (mediante el cristal líquido) emitida para cada píxel, de forma que emite el color deseado. Estas pantallas tienen un consumo energético muy inferior al plasma, pero con una calidad de imagen menor.

Existen muchas tecnologías nuevas que pretenden desmarcarse a la hora de sustituir al LCD y al PDP. Destacan las televisiones de nanocristal, que consiguen mejor calidad de imagen que el PDP y menor consumo energético que el LCD. Miembros del Samsung Advanced Institute of Technology (Yongin, Corea del Sur), liderados por el ingeniero electrónico Byoung Lyong Choi, han construido una pantalla a color basada en "puntos cuánticos de nanocristal". Éstos consiguen en los píxeles rojos un 50% más de brillo y un 70% menos de consumo.

Los puntos cuánticos son cristales semiconductores, con un diámetro de una milmillonésima parte de un metro, que emiten luz a diferentes longitudes de onda (diferentes colores). Esta tecnología tiene una década de antigüedad, pero hasta ahora no se habían solucionado los problemas que aparecían a la hora de construir grandes pantallas sin comprometer la calidad de imagen. El equipo de Samsung ha conseguido solucionar estos problemas. Para ello, utilizaron una oblea de silicio modelada como un “sello de tinta” para recoger las tiras de puntos hechos de seleniuro de cadmio, y presionarlo sobre un substrato de vidrio para crear píxeles rojos verdes y azules sin necesidad de utilizar un disolvente.

Las pantallas de nanocristal son una tecnología muy prometedora, debido a sus ventajas, ya mencionadas: mayor calidad de imagen y menor consumo. No debemos olvidar que todo gasto de energía es una carga para el planeta, por lo que deberíamos reducirlo al mínimo de todas las maneras que estén en nuestro poder.

Fuentes:

es.wikipedia.org

www.e-ciencia.com

martes, 8 de marzo de 2011

Materiales del futuro IV: Nanotubos de Carbono

Los nanotubos de carbono son una forma de cristalizar de este material, en una estructura parecida al diamante o el grafito. Su estructura se puede considerar como una lámina de grafito enrollada sobre sí misma. Dependiendo del grado de enrollamiento y la manera como se conforma la lámina original, el resultado puede llevar a nanotubos de distinto diámetro y estructura interna. Los nanotubos conformados como si las esquinas de un folio se uniesen por sus extremos formando un canuto, se denominan nanotubos monocapa. Existen también nanotubos cuya estructura se asemeja a la de una serie de tubos concéntricos, incluidos unos dentro de otros igual que las muñecas rusas. Estos últimos son los denominados nanotubos multicapa.

Nanotubos Monocapa

Los nanotubos están siendo estudiados por su interés fundamental para la química y por sus aplicaciones tecnológicas. Es, por ejemplo, la primera sustancia conocida por la humanidad capaz de sustentar indefinidamente su propio peso, una condición necesaria para la construcción de un ascensor espacial.

APLICACIONES

Electroquímicas. Una importante aplicación de los nanotubos, dada su gran superficie y su baja resistividad, es la electroquímica, como el desarrollo de supercondensadores, dispositivos para el almacenamiento de hidrógeno y fabricación de celdas solares.

Electrónica. De entre las aplicaciones de los nanotubos de carbono, quizá las más interesantes se encuentren en el dominio de la electrónica, ya que éstos pueden desempeñar el mismo papel que el silicio en los dispositivos electrónicos pero a escala molecular, donde los semiconductores dejan de funcionar. Además, debido a que los avances en la industria electrónica se basan en hacer los dispositivos cada vez mas diminutos, que conlleva un aumento en el rendimiento de la velocidad de proceso y la densidad de los circuitos, será necesario utilizar nanotubos de carbono en su fabricación. Los nanotubos de carbono pueden ser utilizados para fabricar múltiples dispositivos entre los que destacan los transistores y las memorias informáticas.

Otras aplicaciones industriales.

- Biomedicina: Investigadores de universidades italianas han hecho crecer celulas nerviosas en sustratos, cubiertos por redes de nanotubos de carbono.

- Automóviles: Mangueras antiestáticas de combustible.

- Automóviles: Partes plásticas conductoras para pintado con spray electrostático

- Aeroespacio: Partes de aviones

- Packaging: Antiestático para electrónicos

- Tintas conductoras

- Materiales extremadamente negros: La sustancia más oscura conocida, hasta la fecha, se ha creado a partir de nanotubos de carbono.

- Deportes: Debido a la alta resistencia mecánica de los nanotubos, se están empezando a utilizar para hacer más fuertes las raquetas de tenis, manillares de bicicletas, palos de golf, y flechas de ultima generación.

es.wikipedia.org

nanotubosdecarbono.com

jueves, 3 de marzo de 2011

Curiosidades I: Manifestaciones: ¿cómo contar los asistentes?

La respuesta se halla, como suele pasar, en la tecnología. Por poner un ejemplo actual, consideremos la Plaza de la Liberación (Al Tahrir Square) en El Cairo, capital de Egipto. Allí han tenido lugar las protestas contra el régimen dictatorial de Hosni Mubarak, gobernante autoritario de Egipto durante 30 largos años. Se utilizan aplicaciones como el famoso "Manifestómetro", que se sirve de Google Maps para calcular la asistencia a la manifestación. Se establece una densidad máxima de personas (en el caso de la Plaza de la Liberación, 6 personas por metro cuadrado), se descuentan elementos tales como mobiliario urbano y árboles para conseguir una mayor precisión, y se mide la superficie ocupada por los manifestantes. De esta forma, podemos conseguir una cifra muy aproximada de los manifestantes.

En nuestro país, la Policía se suele servir de planos y fotografías de superficie y aéreas para medir la densidad de personas por metro cuadrado y la superficie ocupada, y después se sirven de software especializado para realizar los cálculos pertinentes. Desde luego, nosotros también podemos calcular de forma aproximada los asistentes a la manifestación, con herramientas como el anteriormente citado "Manifestómetro", SIGPAC, ...

Desde luego, que una manifestación sea o no apropiada es muy subjetivo. Pero lo que es más objetivo es el número de asistentes, por mucho que los medios tergiversen estos datos según sus intereses. En mi humilde punto de vista, la manifestación de Al Tahrir Square se cuenta dentro de las justificadas.

Fuentes:

www.e-ciencia.com

Imágenes de Google

lunes, 28 de febrero de 2011

Materiales del futuro III: Nanofluidos como líquidos refrigerantes.

En la medicina, por ejemplo, la nanotecnología es puntera en las investigaciones del trato de las células cancerígenas o en sistemas de transporte de medicamentos en la sangre de formas muy precisas. Para hacernos una idea de los usos más cotidianos de las nanopartículas, las podemos encontrar en cremas solares, haciendo que estas no queden tan visibles en la piel, o en las pelotas de tenis Wilson, que llevan una capa de nanopartículas de arcilla que las hacen más resistentes y que hacen que el aire no pueda escapar de su interior tan fácilmente.

Los descubrimientos de las nanopartículas y sus propiedades no dejan de sorprender a la comunidad científica, ya que al ser una ciencia tan nueva, todavía presenta muchas dudas y curiosidades.

Nanohex: nanofluidos y ventajas térmicas

Nanohex es un proyecto que involucra a 12 organizaciones de 6 países diferentes. Entre ellos encontramos ENEA, en Casaccia, a 25 kilómetros al norte de Roma. Este centro de investigación cuenta con unas instalaciones que se extienden a lo largo de 90 hectáreas, y con más de 1.400 trabajadores.

El proyecto Nanohex, pretende desarrollar nanofluidos como líquidos refrigerantes para su aplicación industrial. Las nanopartículas han demostrado que tienen propiedades térmicas de difusión muy buenas, haciendo que los líquidos refrigerantes mejoren sus propiedades, ya que dispersan el calor más rápido, mejor y de una manera más eficiente.

El proyecto comenzó en 2009 y se prevé que se alargue hasta 2011. En el centro que ENEA tiene en Casaccia hay dos unidades involucradas: el laboratorio de espectroscopía láser en materiales funcionales y el laboratorio de termofluidodinámica aplicada a los sistemas energéticos.

Mauro Falconieri es el jefe del laboratorio de espectroscopía láser y materiales funcionales. La espectroscopía láser estudia como los materiales reaccionan cuando se produce un cambio de energía en su interior: a través de la señal que estos emiten al ser excitados con el láser se pueden estudiar múltiples características. Este es el método que escogió Mauro en su misión dentro del proyecto Nanohex.

Flaminia Rondino, estudiante de post-doctorado, también forma parte de este proyecto. Su misión es estudiar las propiedades térmicas y dispersivas de las nanopartículas de titanio, para así conseguir el nanofluido con mejores cualidades. En un futuro también tienen intención de estudiar las de silicio. En Frascatti, ENEA tiene otras instalaciones donde se encargan de producir las muestras de nanopartículas. Pero su estudio mediante la espectroscopía láser es todo un proceso, sólo para que los láseres mediante los que se hará el experimento estén perfectamente alineados se pueden necesitar semanas de preparación.

El otro departamento en Casaccia, el laboratorio de termofluidodinámica aplicada a sistemas energéticos, estudia las propiedades de estos nanofluidos comparados a tiempo real con otros refrigerantes comunes en el uso industrial como el agua. Al compararlos a tiempo real y en mismas condiciones, pueden averiguar que ventajas supone el nanofluido respecto al agua en cuanto a sus propiedades térmicas pero también en las propiedades corrosivas, otro aspecto que se tiene que tener en cuenta ya que tiene es muy importante de cara a la aplicación industrial.

Nanohex y sus propósitos

Para que un proyecto como este funcione tiene que haber industrias involucradas, que el que se implique en el consumidor final. Y éste es el caso de Nanohex, cuyos dos mayores objetivos públicos involucrados son Thermacore Europe, que es el mayor proveedor de líquidos refrigerantes para centros de datos, y Siemens, que lo quiere aplicar en la tecnología electrónica de los trenes.

El uso de nanofludios por parte de las empresas puede suponer muchas ventajas: los nanofluidos, al ser más eficientes tienen mejor conductividad y propiedades térmicas pueden suponer una mejora en lo que supone al ahorro energético. También hay que tener en cuenta la reducción de espacio que se gana al no tener que usar tantas cantidades de líquido, algo muy interesante para la industria aeroespacial. También hay que tener en cuenta la reducción en las emisiones de dióxido de carbono.

Fuente

tendencias21.net

mundociencia.portalmundos.com

viernes, 25 de febrero de 2011

Tecnologías para el futuro III: simuladores cuánticos

Coloquialmente, la física cuántica es la rama de la física que estudia las cosas muy pequeñas, como las partículas subatómicas. De forma general, se suele decir que la física cuántica estudia las cosas muy pequeñas, la mecánica clásica las cosas "normales", y la relatividad las cosas muy grandes, del orden de estrellas, planetas y galaxias.

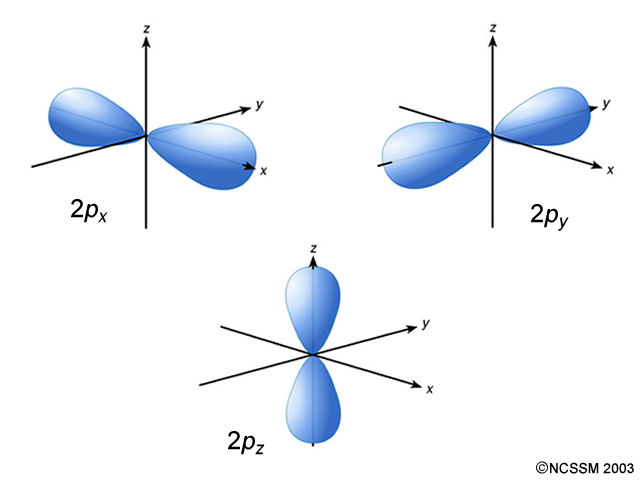

La física cuántica se desarrolló a principios del siglo XX, cuando la teoría electromagnética clásica se volvió del todo insuficiente para explicar las emisiones de radiación de los objetos en equilibrio (radiación térmica), lo que fue solucionado por Plank al considerar la cuantización de la energía (la energía no se puede transmitir con cualquier valor, sino sólo con múltiplos enteros de un determinado valor, el de la constante de Plank) y perfeccionado por el archiconocido Einstein en su teoría del efecto fotoeléctrico, que le valió el Premio Nobel de Física de 1921. La física cuántica se completa con la propuesta de De Broglie, que afirma que cada partícula en movimiento tiene asociada una onda (dualidad onda-corpúsculo), cuya longitud es inversamente proporcional a la masa de la partícula, y que depende de su velocidad. Erwin Schrödinger fue el que perfeccionó este principio, formulando una ecuación de movimiento para estas "ondas de materia", que fue comprobada empíricamente. También es muy importante el principio de incertidumbre de Heisenberg, que afirma que no se puede conocer con total precisión y simultáneamente la posición y el momento lineal (masa y velocidad) de una partícula. Esto es responsable de que la física cuántica trabaje con probabilidades (los conocidos orbitales atómicos, zonas con alta probabilidad de encontrar un electrón, en lugar de las órbitas electrónicas definidas contempladas en la mecánica cuántica).

Orbitales p, los segundos orbitales atómicos en cuanto a energía. Los otros orbitales son los s (menor energía), los d y los f (mayor energía)

La física cuántica es responsable de avances en campos como la electrónica (transistores, microprocesadores, ...) en la física de materiales (semiconductores y superconductores), medicina (cirugía láser, exploración radiológica, ...) y muchas otras áreas del conocimiento.

La dificultad del estudio de la cuántica radica en que las partículas que estudia son de tamaño infinitesimal, por lo que las observaciones y mediciones son enormemente complicadas de realizar. Con el fin de facilitar el estudio de las partículas subatómicas, un equipo de expertos ha desarrollado un "simulador cuántico", una máquina capaz de funcionar según las leyes de la física cuántica (recordemos que los objetos de tamaño normal se comportan según las leyes de la mecánica clásica).

Recientemente, científicos del Instituto de Física Experimental y Física Teórica de Innsbruck, Austria, en colaboración con investigadores del Instituto de Óptica Cuántica e Información Cuántica (IQOQI) han logrado otro avance al respecto. Han desarrollado un mecanismo que servirá para crear simuladores cuánticos de sistema abierto, esto es, simuladores capaces de interactuar con el entorno. Estos simuladores aprovechan un efecto que normalmente se intenta evitar en el uso de máquinas cuánticas: las perturbaciones ambientales. Estas perturbaciones suelen causar que la información en los sistemas cuánticos se pierda, pero este equipo ha conseguido controlar las perturbaciones, consiguiendo intensificar los efectos cuánticos y, al mismo tiempo, que el sistema pueda interactuar con el entorno.

Quizás este sea el paso que nos ayude a comprender mejor nuestro Universo. Los físicos han intentado larga e infructuosamente unificar las teorías de la física cuántica y la relatividad para conseguir la "teoría del todo", desarrollando teorías como la Teoría Unificada de Campos o la Teoría M. De momento no lo han conseguido, pero un mayor dominio de la mecánica cuántica puede ayudarnos en nuestro propósito.

Fuentes:

es.wikipedia.org

www.tendencias21.net

www.ojocientifico.com

martes, 22 de febrero de 2011

Tecnologías para el futuro II: nueva técnica para realizar proyecciones en lugares luminosos

Los proyectores de vídeo son mayoritariamente usados en salas de presentaciones o conferencias, en aulas, aunque también se pueden encontrar aplicaciones para cine en casa. Cuando es así, los lugares deben encontrarse a oscuras para aumentar la visibilidad de las imágenes ofrecidas por este aparato. Desafortunadamente, desde hace tiempo, el hecho de estar a oscuras empezó a presentar varias cuestiones. La más destacada por los que suelen utilizarlo frecuentemente es la incompatibilidad que presenta con sitios iluminados y que causa el agotamiento del público.

Un grupo de expertos del Instituto Fraunhofer de Circuitos Integrados presentó una alternativa de cañón que promete terminar con el agotamiento de los espectadores.

Con la ayuda de la nanotecnología los investigadores desarrollaron un cubo luminoso que proyecta imágenes tan nítidas y fuertes que serán capaces de observarse hasta en una habitación llena de sol.

Esta revolucionaria técnica permitirá ponerle fin al apagado de luz para cuando se realicen largas proyecciones. De esta manera, al parecer, los proyectores del futuro no serán solamente compactos, pequeños y fáciles de manipular, también contarán con colores de alta definición. Todo gracias a la microtecnología.

Lo noveodoso de esta tecnología de proyección es que la imagen ya está integrada en la microóptica. Los píxeles, que miden alrededor de cien nanómetros, se almacenan en una capa de cromo en la lente. Los microarrays tiene alrededor de 250 microlentes y debajo de cada lente hay una microimagen. Cuando todos ellos se proyectan en la pared en conjunto, se origina una imagen completa de alta calidad.

El nuevo proyector está compuesto por un sistema óptico de sólo once milímetros cuadrados y tres milímetros de espesor, a través del cual resplandece una intensa lámpara de diodos emisores de luz. Las imágenes son increíblemente fuertes y los colores sumamente brillantes. A demás de los proyectores de video, este avance también tiene el potencial suficiente como para ser incluido de manera satisfactoria en las cámaras digitales.

Fuente:

tendencias21.net

jovenclub.cu

martes, 15 de febrero de 2011

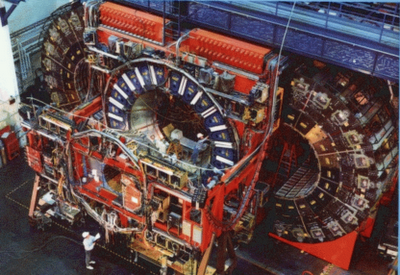

El colisionador de partículas "Tevatron" será desactivado

El Tevatron es un acelerador circular, que acelera protones y antiprotones hasta energías de 1 teraelectrónvoltio, de donde procede su nombre. Su circunferencia mide 6,3km, y su construcción costó 120 millones de dólares. Además ha sido sometido a actualizaciones frecuentes, como la adición del inyector principal, que costó 290 millones de dólares. Entre los mayores méritos del Tevatron se encuentran el descubrimiento del quark "cima" (1995) y del neutrino tauónico (2000). Además, en 2007 midieron la energía del quark "top" con una precisión del 1%.

Las ventajas del LHC sobre el Tevatron se centran, principalmente, en la energía, ya que el LHC supera con creces el teraelectrónvoltio. Sin embargo, los responsables del Tevatron, entre ellos el famoso doctor Robert Brinkman, sostienen que podría encontrar por sí solo el bosón de Higgs para finales de 2012 . Sin embargo, sin obtener una ampliación del presupuesto del Fermilab, se han visto obligados a prescindir del Tevatron para beneficiar otros proyectos, como la determinación de las propiedades de los neutrinos, dejando la búsqueda del Higgs para los europeos del CERN.

Fuentes:

www.ojocientifico.com

es.wikipedia.org

miércoles, 9 de febrero de 2011

Betelgeuse o el segundo Sol de la Tierra

Las estrellas atraviesan distintas fases a lo largo de su vida, periodos muy largos a nuestros ojos (de varios millones de años), aunque no tan largos en términos astronómicos. Estas fases dependen, entre otros factores, de la masa de la estrella. Esta masa está comprendida entre 0.08 y 200 veces la masa del Sol. Por debajo de 0.08M (M = masa solar) hablaríamos de una enana marrón, mientras que no se conoce ninguna estrella por encima de 200M, debido a lo que se conoce como "límite de Eddington".

La primera fase de la vida de una estrella es la "protoestrella": en el seno de una nebulosa, la materia (principalmente hidrógeno, el elemento más ligero del universo) se agrupa por acción de la gravedad, comprimiéndose en torno a un núcleo y, por tanto, aumentando su temperatura. Cuando se alcanza una temperatura crítica, se inicia la fusión nuclear del hidrógeno (la estrella se "enciende"), formándose helio y desprendiéndose una enorme cantidad de energía. Esta sería la segunda y más larga fase de la vida de una estrella. Durante esta etapa, la fuerza gravitatoria tiende a comprimir la estrella y una fuerza resultante de la fusión nuclear equilibra la balanza, permaneciendo la estrella en equilibrio.

Cuando se agota el hidrógeno es cuando entra en juego la masa de la estrella. Las estrellas se convierten en gigantes rojas, tanto mayores cuanto mayor sea su masa. Y este es el caso de Betelgeuse, una supergigante roja, que es la que nos ocupa en esta entrada. (Algún día profundizaremos en las etapas de vida finales de una estrella, la formación de cuásares y agujeros negros, ...)

Betelgeuse es una supergigante roja perteneciente a nuestra galaxia, localizada en el brazo de Orión (recordemos que la Vía Láctea es una galaxia espiral). También conocida como α Orionis o HIP 27989, tiene una temperatura superficial de unos 3000 grados Kelvin, y fue descubierta por sir John Herschel en 1836. Es una de las estrellas más brillantes de Orión, y la más brillante si nos centramos en el espectro rojo-infrarrojo. Su tamaño es tal que, si la colocásemos en la posición del Sol, su radio alcanzaría hasta Júpiter.

Las supergigantes rojas se caracterizan por fusionar elementos pesados en su núcleo. Una vez han consumido el helio resultante de su primera etapa de vida, que fusionan para formar carbono, siguen avanzando por la tabla periódica para llegar al hierro, Fe. La fusión nuclear que da lugar al hierro, a diferencia de las demás, es endotérmica, esto es, necesita más energía para producirse de la que se desprende. Por tanto, en el núcleo de la estrella se acumula hierro, que solidifica a causa de la fuerza gravitatoria. Cuando la energía resultante de la fusión nuclear no puede mantener a la estrella, las capas gaseosas externas colapsan debido a la atracción gravitatoria del núcleo de hierro, chocando violentamente contra éste, y produciéndose una explosión violentísima, en la que se generan los elementos de masa atómica superior a la del Fe. Esto es lo que se llama una supernova, y se trata del proceso más energético del universo.

Recientemente, astrónomos de reconocida fama han afirmado que la estrella Betelgeuse está a punto de colapsar. A punto en términos astronómicos, lo que significa que en el próximo millón de años podría producirse la supernova (que tardaríamos 640 años en ver, lo que tardaría la luz en llegar hasta la Tierra). Gracias a esto, y durante algunas semanas, la Tierra tendrá dos soles, y la noche será indistinguible del día durante todo ese tiempo. No es la primera vez que esto ocurre, ya que, en el año 185 de nuestra era, astrónomos chinos observaron una supernova a 8200 años luz de la Tierra, supernova que también fue avistada por los astrónomos romanos, y que fue verificada por astrónomos modernos al localizarse los restos de la estrella.

De ser cierto, sería un acontecimiento extraordinario, que difícilmente podría presenciar la Tierra en otra ocasión.

Fuentes:

www.ojocientifico.com

es.wikipedia.org

martes, 8 de febrero de 2011

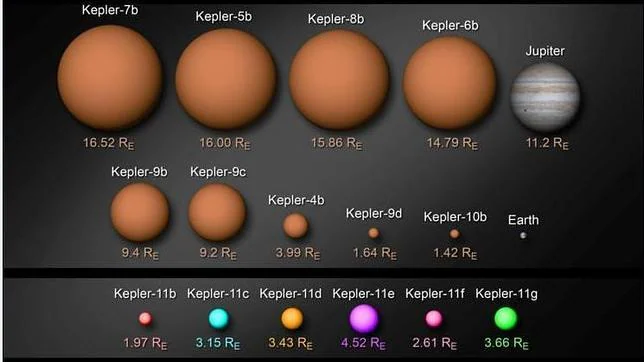

Se descubre un sistema planetario parecido al solar

Según información de la NASA, este sistema contiene planetas de un tamaño parecido a la Tierra y entre ellos los primeros se encuentran orbitando en la denominada zona habitable, una región a una distancia de una estrella suficiente como para que pueda haber agua líquida en su superficie.

Los cinco planetas interiores del sistema Kepler-11 poseen entre 2,3 y 13,5 veces la masa de la Tierra. Sus periodos orbitales son de menos de 50 días. El sexto planeta es mayor y está más alejado, con un periodo orbital de 118 días y una masa que todavía no se conoce.

Como explicó el director del trabajo, los planetas más masivos son posiblemente como Neptuno y Urano pero los tres con menos masa son distintos a los existentes en el Sistema Solar.

El telescopio Kepler y otros similares han detectado más de 100 planetas en tránsito pero la gran mayoría de ellos son gigantes de gas similares a Júpiter y casi todos pertenecen a sistemas de un único planeta.

Antes de esto los astrónomos habían determinado tanto el tamaño como la masa de los mas pequeños que Neptuno. Ahora, un único sistema planetario ha añadido cinco más. El sexto planeta en Kepler-11 está lo suficientemente separado de los otros que el método empleado en el resto de planetas sólo puede determinar su masa. Como en el caso del Sistema Solar, todos los planetas de Kepler-11 orbitan más o menos en el mismo plano.

Este descubrimiento refuerza la idea de que los planetas se forman en discos aplanados de gas y polvo que giran alrededor de una estrella y el patrón de disco se mantiene después de que los planetas se hayan formado.

La importancia del descubrimiento viene dada porque un sistema de seis planetas permite a los investigadores realizar comparaciones entre ellos además de comparaciones con nuestro sistema.

Las densidades de los planetas proporcionan pistas sobre sus composiciones. Los seis planetas tienen densidades inferiores a la de la Tierra. "Parece que los dos más interiores podrían ser principalmente agua, con posiblemente una fina capa de gas de hidrógeno-helio en la superficie, como mini-Neptunos". Los que están más alejados tienen densidades menores a la del agua, que parecen indicar atmósferas de hidrógeno-helio. Esto sorprende a los investigadores porque un pequeño planeta caliente tendría difícil mantener una atmósfera ligera. "Estos planetas son muy calientes por sus órbitas cercanas y cuanto más caliente son más gravedad necesitan para mantener la atmósfera".

Los planetas más interiores están tan juntos que parecen improbable que se formaran donde se encuentran ahora. "Al menos algunos debieron formarse más lejos y migrar hacia el interior. Si un planeta se integra en un disco de gas, con el tiempo las fuerzas de arrastre lo conducen hacia el interior. Por lo que la formación y migración tuvieron que suceder mucho antes".

Fuente:

Europapress.es

abc.es

Leandro Mesas

martes, 25 de enero de 2011

Materiales del futuro II: Vidrio metálico

Según Robert Ritchie, especialista en ciencia de materiales y líder de la investigación, los resultados obtenidos marcan el éxito de una nueva estrategia para la fabricación de vidrio metálico, en el marco de un escenario abierto hacia el futuro para lograr que este cristal sea aún más fuerte y duradero.

La gran novedad que incorpora el nuevo vidrio se encuentra en su estructura y es la incorporación de paladio, un metal con una elevada rigidez y excelentes condiciones de resistencia, que permite contrarrestar la fragilidad de estos materiales.

Una de las características mas importante de este material es que al someterse a distintas condiciones de estrés reacciona con una importante plasticidad. En consecuencia, llega a doblarse pero no se quiebra.

Por otro lado, una de las cosas pendientes en anteriores investigaciones sobre este material era la propagación de grietas en el material frente a distintas circunstancias. En este nuevo trabajo, la creación de un material de cristal puro ha permitido superar este inconveniente.

De otra forma, la composición química desarrollada actúa de tal forma que incrementa la plasticidad del material, impidiendo la formación de grietas. La adición del paladio le da a este material una capacidad inusual de resistencia, permitiendo una maxima protección frente a las grietas.

Estas características promueven una resistencia a la fractura comparable a la obtenida en los materiales más resistentes conocidos hasta hoy. La extraña combinación de dureza y resistencia obtenida en estos nuevos vidrios metálicos se extiende más allá de los rangos de referencia establecidos para los materiales más resistentes y robustos que pueden hallarse en la actualidad.

Tendencias21.net

www.abc.es